Imagine que mientras conduce, su coche puede capturar información sobre su estado emocional por medio de sensores, cámaras y procesadores de audio integrados en el cinturón de seguridad, el volante y la cabina, capaces de detectar sus ritmos cardíaco y respiratorio, su sudoración y la presión de sus manos o de analizar su voz cuando habla con el navegador automático.

Estos sistemas entregan a los sistemas inteligentes de nuestro coche información sobre nuestro estado emocional, la cual puede ser utilizada por nuestro vehículo inteligente para efectuar una serie de intervenciones que mejoren nuestra experiencia de conducción y aumenten nuestro confort.

Este ejemplo referido a la conducción asistida, es solo una de las aplicaciones que tendremos en muchos de los dispositivos o máquinas con las que ya interactuamos. Es la Computación Afectiva (CA), según informan dos profesores de Estudios de Informática, Multimedia y Telecomunicación Catalunya, de la Universitat Oberta de Catalunya (UOC) en Barcelona, España.

Esta tecnología, que explora nuestras emociones y puede llegar a reconocer cómo nos sentimos, ha dejado de ser una utopía según la UOC.

También señalan que las inversiones en este mercado podrían llegar hasta los 90,000 millones de dólares en 2024, según un estudio de MarketsandMarkets.

Esta nueva tecnología promete, desde cambiar nuestras relaciones con las empresas, haciéndolas más agradables y cálidas, hasta mejorar nuestra experiencia de conducción adaptando la temperatura o la música a nuestro estado emocional, pasando por detectar, de forma precoz, problemas psicológicos en sus primeras fases, según la UOC.

MÚLTIPLES APLICACIONES EN LA VIDA DIARIA

La CA podría aplicarse para asistir a personas mayores, detectar precozmente la depresión y la demencia, reducir el estrés, detectar en redes sociales a personas en riesgo de suicidio, ayudar a dejar de fumar, conseguir comer de forma más saludable, o favorecer la expresividad facial y comunicación emocional de los niños con trastorno autista.

En el campo educativo las tecnologías con inteligencia emocional podrían ayudar a detectar la frustración de un estudiante cuando no entiende algo, o a diseñar técnicas de enseñanza que creen interés, despierten la curiosidad o capten la atención, añade la UOC.

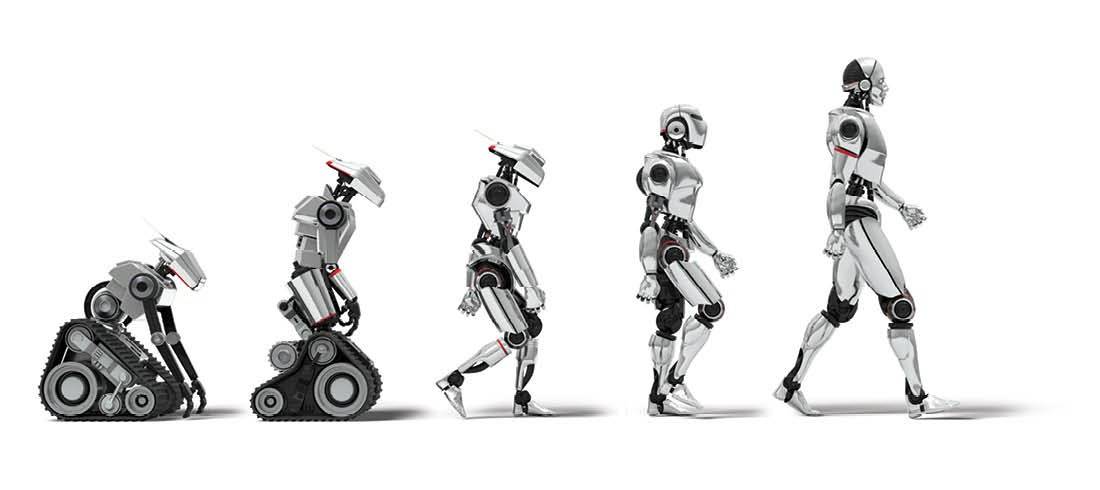

«La posibilidad de que un robot o una máquina pudieran desarrollar empatía (capacidad de identificarse con alguien y compartir sus sentimientos) fue una de las razones de que naciera la CA o Inteligencia Artificial Emocional (IAE)«, según la profesora Ágata Lapedriza.

Lapedriza señala que esta disciplina “estudia cómo crear máquinas que puedan reconocer e interpretar apropiadamente las emociones humanas, y responder a dichas emociones”.

Para hacer realidad esas máquinas, se trata de captar señales relacionadas con nuestro estado de ánimo.

«Para conseguirlo pueden usarse cámaras que observen los movimientos faciales o gestos de una persona; sensores que capturen señales fisiológicas, como los latidos o la respiración; o micrófonos que analicen los cambios de entonación», apunta esta profesora.

«Esas señales transmiten información que por medio de técnicas de aprendizaje automático (machine learning) y establecen patrones que determinan el estado emocional de una persona«, explica Lapedriza.

MAQUINAS CON INTELIGENCIA EMOCIONAL

En el futuro, un teléfono móvil con CA podría detectar nuestro estado emocional a través de la presión que hagamos al usar el teclado, mayor cuando estamos nerviosos, o de las características de nuestra voz, según Lapedriza.

«Si el móvil detecta que estamos experimentando una emoción negativa podrá intervenir para ayudarnos a hacernos sentir mejor. Por ejemplo, si detecta estrés, podrá sugerirnos dar un paseo o proponernos unos ejercicios de respiración o meditación«, apunta.

Los asistentes como Alexa podrían analizar la voz del usuario para detectar su malestar o frustración, cuando tenga que pedirle al dispositivo que repita lo que dijo porque no se entendió.

Así, la máquina podría aprender a disculparse, con un comportamiento emocionalmente inteligente, según esta profesora.

«Asimismo, un robot aspirador del futuro, con cámara y micrófono, podría “darse cuenta” de que está molestando al usuario al interponerse en su camino, analizando sus palabras, gestos o expresión facial, y entonces aspirar en otra zona de la casa o volver a su base para seguir limpiando en otro momento«, señala.

“Esta tecnología está a punto de desembarcar en nuestro día a día”, señala por su parte el profesor David Masip, poniendo como ejemplo a la compañía australiana Akin, “con la que la NASA trabaja para que un asistente de inteligencia artificial pueda dar apoyo emocional a los astronautas”.

Uno de los objetivos de este campo de investigación es conseguir que las máquinas proporcionen servicio “de una forma ubicua y natural en los quehaceres diarios, anticipándose a nuestras necesidades, algo posible si son capaces de entendernos y conocer nuestro estado de ánimo. A partir de ahí, podrían tomar decisiones en consecuencia«, según Masip.

«Necesitamos que los robots nos miren y nos entiendan al igual que los humanos nos entendemos entre nosotros, para que puedan estar integrados en nuestras vidas«, señala Masip.

Para Masip la CA se integrará en nuestras vidas usando imagen, texto, sonido y movimiento como fuentes de datos para percibir nuestras emociones e interactuando con nosotros a través de las máquinas, dispositivos y plataformas que estemos usando, como el teléfono móvil, los asistentes virtuales Alexa, Siri o Google Home, o de las redes sociales.

«También hay sensores ‘ponibles’, incrustados en collares, pulseras o relojes que podrán tener esta función, al igual que la ‘visión egocéntrica’, mediante una cámara situada en la cabeza o el cuello y que capta lo mismo que mira el usuario«, concluye Masip.

DESTACADOS:

* La Computación Afectiva (CA) busca crear máquinas que reconozcan e interpreten nuestras emociones y respondan a esas emociones, según la Universitat Oberta de Catalunya (UOC).

* «Un teléfono móvil con CA detectará si estamos nerviosos a través de la presión que hagamos al usar el teclado y por la entonación de nuestra voz«, según Àgata Lapedriza, de la UOC.

* «Necesitamos que los robots nos miren y entiendan al igual que nos entendemos entre nosotros, para poder integrarse en nuestras vidas«, apunta David Masip, de esta misma universidad.